Traitement des signaux numériques et abstraction

Pierre-Yves Cruaud, Jacques Perconte, HC Gilje

Mon propos n’est pas de soumettre ici des analyses poussées sur les traitements des signaux numériques ou sur l’abstraction en vidéo, mais, comme le titre de mon intervention l’indique, d’éclairer le point de friction où ces deux champs de la technique d’une part, et de l’art, d’autre part, se rencontrent. Mes considérations viennent de la constatation que parmi les recherches les plus radicales sur l’image numérique depuis les années 90, favorisées par l’accélération des performances des ordinateurs et l’apparition d’une multitude de logiciels de traitement d’images et du son en temps réel, se démarquent des vidéastes et artistes numériques qui expérimentent les médias numériques dans leurs spécificités techniques. Quelles sont ces spécificités ? Le français Pierre-Yves Cruaud offrira une bonne introduction à la notion de signal numérique vidéo et la compréhension que des inventions formelles vertigineuses sont liées à son traitement. Quelle multiplicité de manipulations est-il possible de lui faire subir, pour quelles formes plastiques radicales ? Les virtuosités techniques de Jacques Perconte en matière d’encodage, puis du norvégien HC Gilje en matière de programmation visuelle permettront d’esquisser deux grandes voies dans les pratiques et les formes d’aujourd’hui.

Selon Patrick Brunet dans son ouvrage Les Outils de l’image : du cinématographe au caméscope :

“les composantes mêmes de la vidéo déterminent presque immanquablement son essence propre qui la situe en termes de rôle et de fonction. La vidéo est avant tout née d’une technologie, son image est celle d’une technicité. Toute tentative de discours esthétique en est empreinte. (…) Sa matérialité cantonne son rayonnement dans les limites de ses composants électroniques et du mode de transport et de véhicule des images qu’elle produit[11][11] Patrick J. Brunet, Les Outils de l’image : du cinématographe au caméscope, Montréal, Les Presses de l’Université de Montréal, coll. « Sciences de la communication », 1992, pp. 108-109.“

Ces réflexions sur la vidéo constituent un avertissement à destination de tout analyste qui se doit de comprendre la spécificité de ce médium et, pour se faire, de revenir à sa matérialité si souvent oubliée en raison des modes d’apparition de l’image électronique (l’écran du téléviseur), de transport (les ondes), de manipulation (l’ordinateur) qui semblent la repousser dans l’immatériel et le virtuel. Soulever cette matérialité signifie également prendre en compte la complexité des technologies électroniques qui font intervenir autant la physique que les mathématiques. Des éléments-clés peuvent être cependant soulevés sans entrer dans les arcanes des hautes technologies. Par exemple, mettre en évidence la distinction fondamentale entre vidéo et cinéma. En effet, le cinéma est héritier de la photographie qui est l’art d’écrire avec la lumière, autrement dit de la technique physico-chimique qui permet d’enregistrer directement ou indirectement toute radiation lumineuse pour former une image ou une trace conservable. La vidéo permet elle d’obtenir des images purement électriques et de révéler ces images sans aucun traitement chimique. Les recherches scientifiques et techniques ont, tout au long du XXe siècle, inventé et perfectionné les technologies adéquates pour l’obtention de l’image électronique par des procédés qui permettent de traduire les intensités lumineuses des éléments de l’image en termes d’impulsions électriques, puis de les traiter aux moyens de circuits analogiques jusqu’à la fin des années 80 et numériques à partir de début des années 90. Les recherches artistiques sur la vidéo ont suivi cette évolution technologique. Ainsi, pour se développer, l’art vidéo a dû tout d’abord compter sur les structures de télévision existantes puisqu’ainsi que le fait remarquer Anne-Marie Duguet dans son ouvrage Vidéo, mémoire au poing, « les exigences esthétiques des artistes, concernant par exemple la qualité de l’image ou la recherche fondamentale sur le dispositif électronique lui-même, les obligent à se tourner vers les institutions qui possèdent des studios correctement équipés »[22][22] Anne-Marie Duguet, Vidéo, mémoire au poing, Hachette, 1981, p.181. C’est cela qui a changé avec le numérique depuis le début des années 90 : la démocratisation et une multiplication massives d’outils numériques de traitement de la vidéo ont permis à l’artiste de travailler en véritable laborantin avec un équipement de pointe.

Les recherches les plus avancées sur l’image vidéo numérique s’inscrivent donc dans une longue pratique d’expérimentations du médium vidéo s’ancrant depuis les années 60 dans une compréhension de la spécificité technique de la vidéo et de ses propriétés et dont le but est l’invention perpétuelle de formes plastiques radicales. Ces recherches sur l’image s’inscrivent plus largement au sein des expérimentations artistiques qui ont eu lieu depuis l’abstraction dans la sphère de la peinture au début du XXe siècle, en passant par le cinéma expérimental jusqu’aux arts numériques.

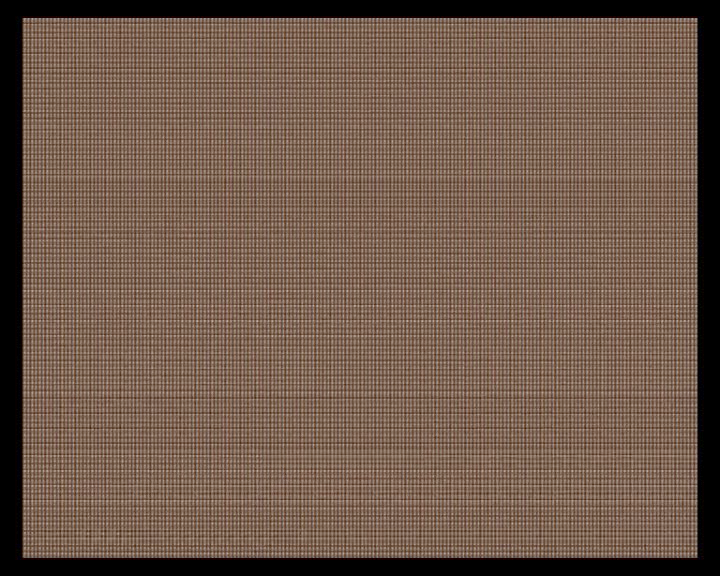

Voici une vidéo de Pierre-Yves Cruaud, L’Hôtel des vies reproductibles (2000), tournée en mini-DV. Pouvant être appréhendée comme une analyse du médium lui-même, elle renvoie à sa propre matérialité, explicite sa nature profonde et ses origines électroniques. Cela va nous permettre d’entrer de plain-pied dans le signal numérique.

Cette œuvre est remarquable dans sa manière de traiter l’image vidéo. On passe d’une mosaïque abstraite à l’élucidation progressive de sa composition, autrement dit, le sujet de la vidéo représente le processus inverse de son élaboration. Pierre-Yves Cruaud a effectué, sous Final Cut Pro, une longue série de réductions de plusieurs images capturées par la caméra numérique associée à leur multiplication dans le cadre, entraînant une démultiplication extrême des images originales jusqu’à ce qu’elles soient réduites à un petit bloc de pixels. C’est une véritable mise en abyme de la trame vidéo constituée de plusieurs centaines de milliers de pixels mais également une évocation des capteurs CCD de la caméra numérique qui ont fait naître l’image.

Quelques mots sur les CCD. C’est en 1970 que Willard Boyle et Georges Smith de Bell Labs font aboutir 10 années de recherches en intégrant sur une même puce les surfaces de conversion lumières-électricité et les dispositifs à transfert de charge : Coupled Charge Device, CCD. Dans les années 80, les caméscopes sont équipés de ces analyseurs à état solide, capteurs micro-électroniques de lumière comprenant de 200 à 300000 pixels. Ces nouvelles caméras intègrent tout d’abord des circuits de traitement analogiques avant de passer au tout numérique au début des années 90. Le micro-circuit est construit sur une pastille carrée de silicium semi-conducteur de 6mm de côté environ et constitue, dans sa partie centrale et sensible, un réseau de plusieurs centaines de milliers d’éléments, réseau qui détermine la définition et la limite de résolution de l’image. Autrement dit, les photocapteurs de la puce CCD forment un réseau matriciel dont chaque rangée correspond à une ligne de l’image vidéo. Le fonctionnement d’un CCD peut se résumer en 3 étapes : tout d’abord la conversion de l’image optique formée par l’objectif en charges électriques proportionnelles à l’énergie lumineuse reçue (quantité de photons) ; puis l’accumulation des paquets de charges ainsi générés dans les photocapteurs ; enfin, le transfert de ces charges, selon le mode propre à la structure du capteur, vers la porte de sortie du circuit afin de former un signal électrique qui sera traité au sein de la caméra pour donner par la suite le signal vidéo numérique. La supériorité technique du signal numérique sur l’analogique réside dans le fait que son traitement au sein de la caméra, son transport et sa reproduction, ne sont pas sujets aux parasites. En effet, le signal analogique véhicule lui-même les valeurs directes de l’image qui a été captée, dans la forme même du signal ; aussi si le traitement du signal analogique rencontre des parasites (au sein de la caméra, les composants étant sujets à des dérives ou des fluctuations – vibrations, température, vieillissement), ces parasites viennent faire partie intégrante du signal électrique. De plus, en cas de copie, il est sujet à des pertes d’informations. Le signal numérique lui se caractérise par le fait qu’il véhicule non plus directement les valeurs du signal d’origine mais des valeurs hautes et basses (binaires : 0 et 1) qui correspondent au langage informatique de l’ordinateur, et qui doivent être décodées par un ordinateur pour être lisible par un être humain. La copie d’un signal numérique est identique à l’original.

Le processus mis au point par les constructeurs de caméra numérique de la captation de l’image optique jusqu’à l’obtention du signal numérique est hyperstandardisé, il se retrouve dans toutes les caméras numériques sur le marché. La formation de l’image optique est obtenue par un objectif, instrument standardisé par excellence contre lequel se sont déjà élevés bon nombre de cinéastes, Patrick Bokanowski par exemple ; à cela il faut ajouter la présence de filtres devant le capteur, notamment un filtre anti-infrarouge qui a pour but d’atténuer la réponse du CCD dans l’infrarouge, afin de la rendre cohérente avec notre propre perception visuelle. De même le codage des informations visuelles se fait au détriment de la chrominance, sous prétexte que l’œil humain possède un pouvoir de résolution beaucoup plus faible pour les détails de couleurs que pour les détails de luminosité (certains codages réduisent jusqu’à 75% la quantité d’information de chrominance par rapport aux informations de luminance). Enfin, le traitement vidéo que fait subir le circuit électronique au sein de la caméra aux signaux électriques issus des capteurs CCD consiste en une batterie de codifications du signal numérique en 11 étapes successives afin d’obtenir une image lisible, propre et acceptable (échantillonnage, corrections de taches au noir, gain, correction de taches au blanc, correction d’ouverture et de contour, correction de masking, correction des pixels défectueux, correction de flare, compressions des blancs, correction de gamma, modulation et multiplexage).

La vidéo numérique est donc un médium bridé par l’industrie pour laquelle elle n’est qu’un outil de masse porteur d’objectifs de rentabilité. Elle ploie sous les dictats commerciaux, telle la volonté des constructeurs d’en faire le nouveau terrain du cinéma ; ainsi doit être lue la course imposée par les constructeurs sur la haute définition de l’image vidéo censée rejoindre progressivement celle de l’image cinématographique, l’objectif étant d’inventer des caméras vidéo à l’image des caméras cinématographiques, seulement plus performantes et confortables d’utilisation. Cela constitue une diversion pour l’art. Les artistes vidéos / numériques qui nous intéressent l’ont bien compris et s’extraient de cette logique-là afin d’explorer la vidéo pour ce qu’elle est. Ce faisant, ils la libèrent. Concevoir la vidéo en tant que signal numérique, c’est reléguer la caméra au rang d’une machine à fabriquer du signal à partir du visible. Cela revient à annihiler l’importance de l’usage de l’outil au profit du processus technique à l’œuvre au sein de l’instrument d’observation, ou encore métaphoriquement, à ouvrir la caméra pour n’en retenir que les circuits électroniques internes.

L’Hôtel des vies reproductibles propose ainsi une manipulation vertigineuse du signal numérique qui aboutit, par fractionnement et multiplication du signal d’origine, à démultiplier jusqu’à l’infiniment petit un plan à l’intérieur du cadre. Cette manière de concevoir la vidéo numérique peut être comparée, toute proportion gardée, à celle que les peintres abstraits avaient du tableau comme étant une surface plane couverte de couleurs et de signes, ou aux interprétations des futuristes Bruno Corra et Arnaldo Ginna qui, dans les années 1910, considéraient que le film consistait avant tout en un ruban d’un matériau transparent défilant dans le projecteur. Le regard discriminant porté sur l’objet technique, cet attachement à la matière du support, à la réalité de ses composants, induit une redécouverte du médium et impulse une invention formelle débridée permettant une expression à la fois plus sensible et plus intellectuelle.

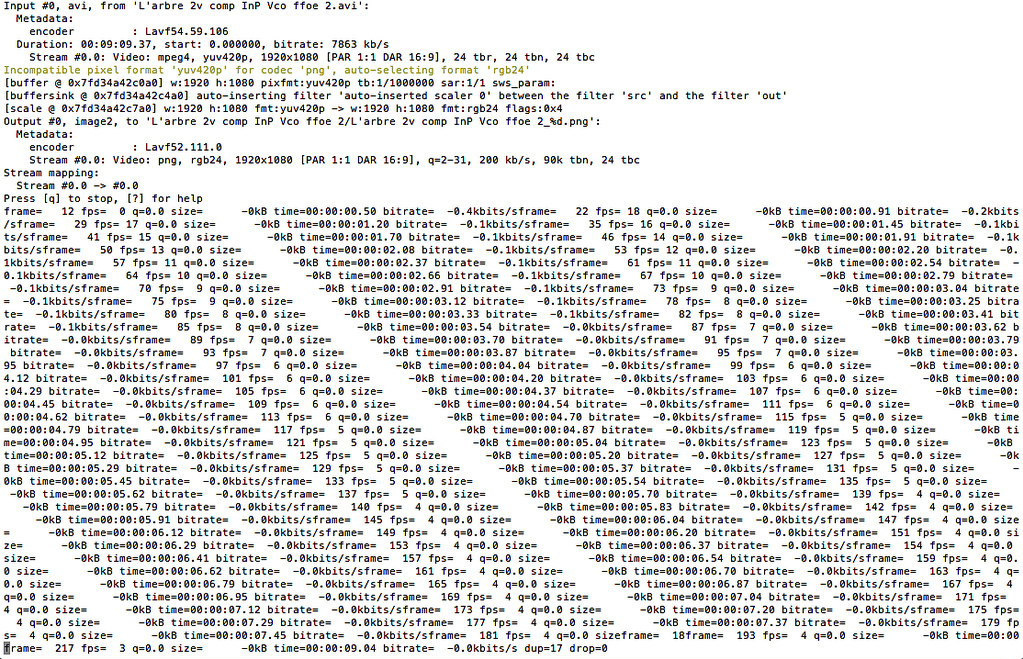

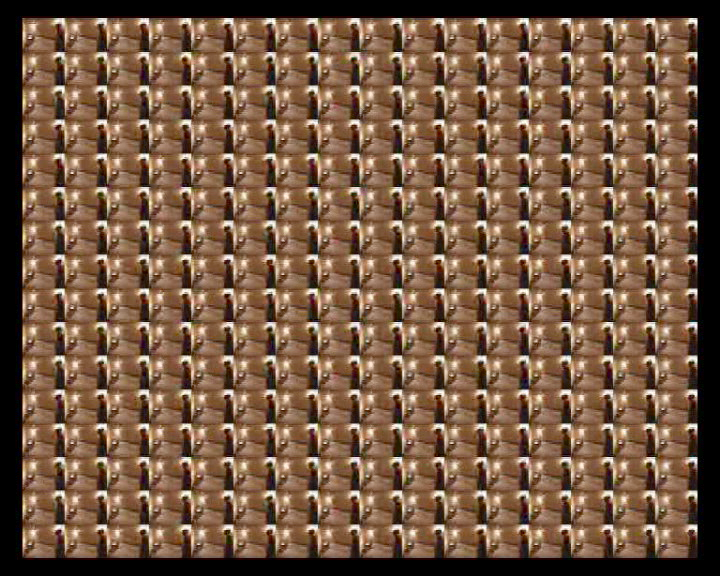

Jacques Perconte a développé tout un ensemble de techniques détournant et dépassant les logiciels d’encodage afin de traiter les signaux numériques de sa caméra, de son appareil photo numérique ou de films téléchargés sur internet. Deux mots, tout d’abord, sur la compression numérique selon l’industrie qui l’a conçue. La compression numérique s’imposant chaque jour davantage, cette technique complexe a quasiment banalisé la manipulation des images vidéo numériques dans les domaines broadcast et grand-public. Elle consiste à réduire la quantité d’information du signal vidéo. Ce n’est pas nouveau, depuis les débuts de l’histoire de la télévision, on a cherché à restreindre à des valeurs raisonnables l’encombrement du signal vidéo (réduction du nombre d’images transmises par seconde, réduction de la définition verticale et horizontale, etc.). Apparue dans les années 80, la numérisation des images vidéo conformément à la norme 4 :2 :2 engendre des volumes de données gigantesques, donc des débits extrêmement élevés au regard des faibles capacités des supports de stockage et de transmission de l’époque. La compression a eu pour but de trouver la manière la plus rationnelle de coder les images (en termes d’encombrement) tout en préservant au maximum leur contenu. Elle supprime certaines informations de l’image et en simplifie d’autres, tout en faisant en sorte que les modifications apportées échappent à la perception humaine. Dans le cas d’une image fixe, les techniques de compression s’appuient sur une analyse du contenu de l’image et tirent profit de son organisation interne afin d’en éliminer les données redondantes, nommées “redondances spatiales”. Par exemple, une image comporte souvent des plages uniformes plus ou moins grandes, composées de pixels identiques que l’on peut coder de manière compacte. Dans une séquence animée, la compression peut, par ailleurs, exploiter le fait qu’il existe très souvent une grande similitude entre plusieurs images successives ; ces redondances temporelles permettent de ne transmettre que les différences entre des images similaires. La plupart du temps, la vitesse des mouvements est largement inférieure à la fréquence de rafraîchissement des images (là aussi une économie de données peut-être réalisée). Concrètement, la compression vidéo fait appel à une variété d’algorithmes de codage qui exploitent les différents types de redondance de l’image.

Jacques Perconte, au rebours des injonctions de l’industrie, choisit et associe ces algorithmes (en particulier le codec DivX) en intimant une réduction du débit dans des facteurs très élevés de manière à ce qu’apparaissent des artefacts et des distorsions dans l’image. Il va beaucoup plus loin que la compression pour un film sur DVD, le DVD compressant le signal vidéo dans un facteur d’environ 25.

Jacques Perconte exploite et exacerbe ce que l’industrie nomme « les défauts » typiques de la compression et interprète comme des dégradations engendrées par une succession de compressions trop poussées. Ces soi-disant défauts constituent la matière même des recherches plastiques de Jacques Perconte. Ils sont au nombre de cinq[33][33] Philippe BELLAICHE, Les Secrets de l’image vidéo : colorimétrie, éclairage, optique, caméra, signal vidéo, compression numérique, formats d’enregistrement, 6e édition, Paris, Eyrolles, 2006, pp.255-256.. Tout d’abord, « l’effet de bloc » : une structure rappelant une mosaïque carrée apparaît à certains endroits de l’image. Ce sont des blocs de pixels qui deviennent visibles à cause des taux de compression très élevés. Également, « l’effet de halo » : des franges apparaissent sur les contours des objets, du fait du débit trop faible. Ou encore « l’effet de bluring » : les détails sont moins nets, les contours moins marqués, avec des effets de traînées. Le quatrième est « le bruit de quantification » : un effet de neige provenant d’un problème local de conversion analogique / numérique contamine l’image de manière non uniforme. Et enfin, « l’effet de moustique » (mosquito noise) : du bruit apparaît sur les transitions d’éléments en mouvement, sous la forme de petits points qui miroitent autour des formes ; il est dû à des erreurs de quantification entre pixels voisins. L’exploitation des spécificités des compressions très élevées articulée à un traitement multi-couches de l’image (superposition d’images de compression différente, création de masques, afin de sélectionner soigneusement les effets des compressions) et à des exacerbations chromatiques impulse au signal vidéo numérique toute son ampleur perdue et révèle des formes d’une densité et d’une richesse insoupçonnée.

HC Gilje, vidéaste et artiste numérique norvégien, a pour sa part développé une chaîne de traitement du signal vidéo tout à fait unique et passionnante. En effet, sa pratique de l’art vidéo l’a orienté vers les démarches de l’art par ordinateur puisqu’il a profité des développements pendant les années 90 d’outils numériques de traitement de la vidéo et du son en temps réel. L’outil numérique révolutionnaire en question est JMax. Le nom de MAX est un hommage à Max Matthews, un des pères de l’informatique musicale. MAX est issu d’un logiciel, l’éditeur Patcher, écrit en 1987 par le mathématicien Miller Puckette pour la réalisation de Pluton, œuvre musicale de Philippe Manoury. Miller Puckette transposa cette première version du logiciel dans le projet de Station d’Informatique Musicale, initié à l’Ircam en 1989, et développa l’environnement de programmation visuelle MAX, alors uniquement conçu pour créer des programmes de traitement de plusieurs signaux numériques audio. JMax, nouvelle implémentation du logiciel MAX sorti en 1998, est un environnement de programmation visuelle pour la réalisation d’applications musicales et multimédia interactives. Les différentes étapes de fabrications des vidéos de HC Gilje sont devenues les suivantes : tout d’abord, la captation en mini-DV (obtention des signaux numériques), puis l’importation d’une partie de ce matériel pour le traiter ensuite avec JMax en temps réel au cours d’improvisations qui ont lieu en général dans des bars, l’enregistrement de ces improvisations, et enfin, le montage de ce matériel sous Final Cut Pro.

Night for Day (2004) offre un langage visuel d’inspiration musicale comme interprétations poétiques et équivalents plastiques de la vie urbaine de Tokyo et de ses espaces architecturaux. JMax permet à HC Gilje de traiter les signaux numériques vidéo de manière radicalement différente que s’il utilisait des logiciels de montage et d’effets spéciaux, extrêmement rudimentaires en regard des expérimentations qu’il veut faire subir aux signaux numériques vidéos. Pour transformer et mixer ces signaux vidéos, HC Gilje élabore des programmes de traitements en temps réel à l’aide des fonctionnalités de JMax : pour ce faire, il construit des patchs en plaçant des modules sur une surface de travail et connecte ces modules par des “fils”. Ces “fils” représentent des canaux de communication sur lesquels des valeurs ou des flux d’échantillons sont échangés entre les modules. Ces modules peuvent être des unités de calcul (arithmétique, temporisations…), des conteneurs stockant des données (tables…), des entrées-sorties sonores ou vidéo. Les modules de MAX sont appelés objets. Ces objets peuvent eux-mêmes être des patchs, donnant ainsi au patch une structure hiérarchique. Certains objets ont un comportement graphique interactif et peuvent être utilisés comme contrôleurs, pour changer des paramètres dans le patch, ou comme visualisation, pour afficher des valeurs calculées par le patch. Cette pratique de la programmation visuelle lui permet de combiner les signaux de manière additive ou soustractive, d’appliquer à n’importe quel instant les effets de son choix et d’en faire varier tous les paramètres, de créer des images dans les images de toutes formes et de toutes tailles et sans limites, et même d’utiliser et de créer des erreurs du programme. C’est ainsi que dans Night for day les images simultanément se saturent, se surexposent, se surimpressionnent ou s’incrustent de manière parcimonieuse, se font granuleuses, sont comme raclées de stries irrégulières blanches et de couleurs horizontales ou verticales, se stratifient et se décomposent et se reconfigurent de manière infinie ; le film accumule et concentre au sein de cette séquence, des écrans, des bandes, des segments d’images par superposition complexe, chacun agissant comme une fenêtre, un cache, un filtre ou un prisme, dans une véritable explosion formelle.

Les travaux de Pierre-Yves Cruaud, Jacques Perconte et HC Gilje, démontrent que logiciels de montage, d’encodage, et environnement de programmation graphique, peuvent être exploités avec virtuosité au-delà du confort de manipulation envisagé par l’industrie qui les a construits. Ainsi, des possibilités insoupçonnées sont découvertes en vue de créer des formes plastiques révolutionnaires poursuivant les enjeux de l’abstraction. Ces artistes récusent l’idée reçue selon laquelle la vidéo numérique serait un médium pauvre ; le déplacement qu’ils opèrent par rapport au médium, impliquant une connaissance concrète des spécificités du signal numérique, leur permet, en s’aidant des avancées techniques et des inventions technologiques, de l’ouvrir et d’expérimenter des chaînes de traitements du signal toujours plus complexes. Le numérique est transformé par ces artistes avant-gardistes en un véritable médium plastique. L’exploration ne fait que débuter

Ce texte a fait l'objet d'une première publication dans Oui, c'est du cinéma : formes et espaces de l'image en mouvement, un ouvrage dirigé par Philippe Dubois, Lúcia Ramos Monteiro et Alessandro Bordina (éditions Campanotto, 2009).

Images : "Capture d’écran 2013-02-16 à 09.42.56", étape de travail sur L'arbre de vie (Jacques Perconte, 2013) / L’Hôtel des vies reproductibles (Pierre-Yves Cruaud, 2000) / Uishet (Jacques Perconte, 2005-2007) / Night for Day (HC Gilje, 2004).